Quand l’IA est l’interlocuteur, le langage devient une interface. Ce que je veux dire, ce n’est pas que “bien s’exprimer” redevienne important. Ça l’a toujours été. C’est que, face à une IA, la formalisation change de nature.

Quand on parle à des humains, on formalise pour aligner : clarifier, convaincre, négocier, obtenir une décision. On tolère une part de flou, parce que l’échange compense. On rattrape une ambiguïté au détour d’une question, d’un regard, d’un “tu veux dire quoi par là ?”.

Face à un LLM, on formalise pour spécifier. On n’essaie pas d’emporter l’adhésion ; on essaie de fermer un espace de solutions. Le langage devient une interface : un moyen de décrire un objectif, de poser des contraintes, d’imposer un format de sortie, d’exiger un niveau de preuve, et de rendre l’ensemble réutilisable.

Si on considère l’exemple d’une direction marketing, ce déplacement est immédiat : la capacité à produire des mots n’est plus rare. La capacité à produire des contraintes testables, elle, l’est encore.

De la persuasion à la spécification

Un simple exemple suffit à voir le basculement.

- Face à un rédacteur humain : “Rédige une landing page pour notre offre SaaS”

- Face à une IA : “Landing page SaaS B2B. Persona : CFO en ETI. Objectif : prise de rendez-vous. Proposition de valeur : réduction du DSO. Objections à traiter : risque, intégration, preuve. 3 variantes d’angle (économie / risque / conformité). 120–150 mots chacune. Ton : sobre, pas de superlatifs, pas de promesses non vérifiables. Ajoute 2 éléments de preuve : un chiffre interne (fourni ci-dessous) et une preuve externe sourcée. Termine par un CTA non agressif.”

La différence n’est pas stylistique. Elle est structurelle : le second prompt contient déjà une stratégie de message minimale, des risques identifiés, des interdits, un format. L’IA n’a pas à deviner ce que l’organisation veut dire.

OpenAI formule ce principe de manière simple : être spécifique (contexte, résultat attendu, longueur, format, style) et, si besoin, montrer le format via des exemples.

Nielsen Norman Group propose une structure mnémotechnique proche : Context / Ask / Rules / Examples (CARE).

Dans une direction marketing, ces cadres ne sont pas des astuces de prompt. Ce sont des outils de gouvernance : ils transforment une intention en spécification.

Pourquoi on change d’échelle et les précautions à prendre

L’argument du changement d’échelle est souvent utilisé comme une promesse vague. On peut le rendre concret avec deux effets observés dans la littérature.

Premier effet : sur des tâches d’écriture professionnelles, l’assistance par ChatGPT a réduit le temps moyen d’environ 40% et augmenté la qualité d’environ 18% (dans un protocole expérimental, sur des tâches d’écriture professionnelle de niveau moyen).

Deuxième effet : en support client, l’introduction d’un assistant conversationnel a augmenté la productivité (résolution de cas par heure) d’environ 14–15% en moyenne, avec une forte hétérogénéité selon l’expérience.

Ces chiffres ne prouvent rien dans le domaine du marketing. Ils donnent une intuition utile : dès que la production textuelle devient plus rapide, l’avantage se déplace vers ce qui encadre la production.

Dans une direction marketing, l’échelle se manifeste de trois façons.

1) Volume

Le contenu devient un flux : variantes d’emails par segment, déclinaisons social par réseau, scripts vidéo, FAQ, briefs créa, pages d’ads, pages produit, messages sales enablement. Quand l’IA accélère la production, elle amplifie mécaniquement la qualité… ou le bruit.

2) Itération

La formulation devient une boucle. On ne commande plus un texte, on itère sur un espace : angle, preuve, objection, structure, ton. Un prompt médiocre ne donne pas un mauvais texte : il engage dans une mauvaise boucle.

3) Standardisation

Le vrai levier managérial apparaît quand une bonne formalisation devient un gabarit réutilisable. Ce n’est plus l’output qui compte, c’est la reproductibilité.

Le danger est symétrique : une organisation peut industrialiser des contenus propres, cohérents… et factuellement fragiles. À grande échelle, un défaut de cadrage n’est pas un défaut local ; c’est un risque systémique.

Le langage comme interface : prompt vs context engineering

Le terme prompt engineering a mis le sujet sur la table, puis il a commencé à masquer le vrai travail : la gestion du contexte.

On peut appeler ça context engineering : sélectionner, organiser et maintenir l’information utile à l’inférence (documents, règles, exemples, définitions, historique), plutôt que bricoler une consigne isolée. Des acteurs de l’écosystème agents/LLM décrivent explicitement cette logique de construction et de gestion du contexte.

Pour un manager marketing, la traduction est simple : l’IA performe surtout quand elle est nourrie d’un contexte stable.

- Une hiérarchie de messages (promesse, preuves, objections).

- Une charte éditoriale compressée (ton, vocabulaire, interdits).

- Des définitions non ambiguës (persona, segment, KPI, “conversion”).

- Des exemples “OK / KO” (ce qui est conforme et ce qui ne l’est pas).

- Un protocole de validation (sources, claims, conformité).

Microsoft insiste aussi sur le rôle des exemples et du format pour diriger le modèle.

NN/g observe que les prompts efficaces contiennent souvent une demande, un contexte, une spécification de format, et des références (internes ou externes).

Le point clé n’est pas: écrire un bon prompt. C’est construire un environnement informationnel dans lequel l’IA ne peut pas facilement dériver.

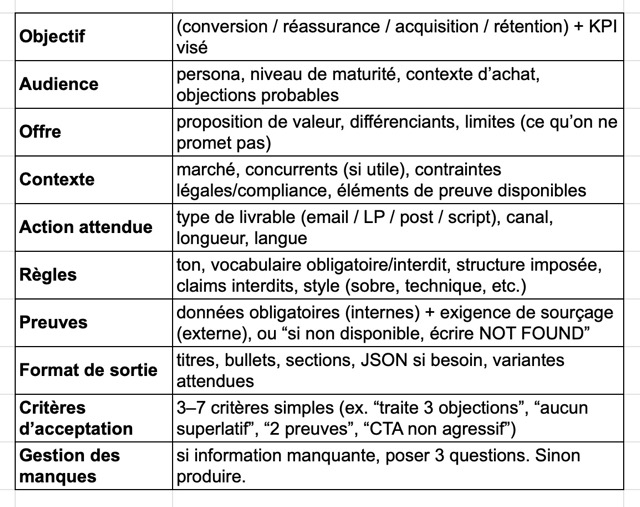

Mini-template : brief LLM pour une direction marketing

Ce template reprend, en version opérationnelle, l’idée de structurer contexte, demande, règles et exemples (CARE) et les recommandations de spécificité/format/exemples.

Briefer sous conditions

Briefer sous condition est une technique de collaboration humain–LLM.

Condition 1 : un “done” explicite

Le “done” n’est pas une impression à la relecture (“c’est bien”). C’est un petit ensemble de critères qui définit la réussite de la tâche.

Exemples marketing :

- 2 preuves, dont une externe sourcée

- 3 objections traitées

- aucun claim absolu (“toujours”, “garanti”)

- CTA non agressif

- 1 version “exécutif” + 1 version “terrain”

- ton conforme à la charte (liste de 10 mots interdits)

Sans “done” explicite, l’IA se comporte comme un stagiaire brillant : elle propose, mais elle ne tranche pas ce qui compte.

Condition 2 : un protocole de vérification

Le coût se déplace vers la validation, parce que l’IA accélère la production et réduit la friction. Deux pratiques simples rendent ce contrôle réaliste :

a) Forcer la séparation “contenu / preuve”.

Demander à l’IA de sortir, après le texte, une liste d’affirmation et, pour chacun, le statut : prouvé / à prouver / impossible à prouver avec les données fournies.

b) Autoriser explicitement “NOT FOUND”.

C’est paradoxal, mais c’est souvent ce qui augmente la qualité : on retire l’incitation à “combler”. OpenAI recommande d’être spécifique sur le format et d’itérer ; cette itération inclut, en pratique, la gestion explicite de ce qui manque.

Condition 3 : gérer la dette cognitive

Le débat public sur : l’IA nous rend-elle plus bêtes ? est devenu bruyant. Il existe des travaux exploratoires qui mesurent, via EEG, des différences d’engagement cognitif entre écriture manuelle, avec moteur de recherche, et avec LLM, et qui parlent d’accumulation de « cognitive debt”.

Deux points importent pour un manager :

- Le signal est intéressant : si l’outil réduit l’effort, il peut réduire l’apprentissage, surtout quand on l’utilise comme substitution plutôt que comme tuteur.

- Le niveau de preuve de cet article est à manier avec prudence : il s’agit d’un preprint (arXiv), et les articles grand public eux-mêmes rappellent les limites méthodologiques et les risques de sur-interprétation.

En pratique, la question managériale n’est pas “pour ou contre”. Elle est : à quel moment du processus l’IA intervient, et avec quel rôle ?Une règle simple évite une partie de la dette : séparer les phases.

Exemple : faire une sortie en 2 passes

- Pass 1 (divergence cadrée) : l’IA propose 3 angles + hypothèses + risques + questions.

- Arbitrage : le manager choisit l’angle, pose les preuves, interdit certaines affirmations (et au passage il s’approprie le sujet).

- Pass 2 (exécution sous contraintes) : l’IA rédige, décline, structure, met en formats.

Ecrire des contraintes testables

Les études sur la productivité en environnement contrôlé et en entreprise ont un point commun : l’IA tend à augmenter la vitesse et, dans certains cas, la qualité — avec une hétérogénéité forte selon l’expérience et selon le type de tâche.

Dans une direction marketing, l’implication est moins “l’IA va écrire à notre place” que “l’IA va déplacer le différentiel de compétence”.

Le différentiel se situe dans :

- la capacité à transformer une stratégie en spécification

- la capacité à rendre la preuve obligatoire

- la capacité à définir des critères d’acceptation

- la capacité à standardiser sans déformer

- la capacité à organiser le contexte (documents, charte, exemples, définitions) et à maintenir cette base

Si on regarde le problème sous cet angle, la formalisation n’est pas une compétence de communication. C’est une compétence de pilotage.

Sources :

- Experimental evidence on the productivity effects of generative artificial intelligence

- Generative AI at Work

- Context Engineering for AI Agents

- Prompt engineering techniques

- Prompt Structure in Conversations with Generative AI

- CARE: Structure for Crafting AI Prompts

- Best practices for prompt engineering with the OpenAI API

- Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task

- Axios AI+

- Experimental evidence on the productivity effects of generative artificial intelligence