Pourquoi votre prompt ne suffit plus ?

“Ce n’est pas ce que vous dites, c’est ce que vous impliquez.” Voilà le nouveau mantra de l’intelligence artificielle générative. Alors que le monde avait les yeux rivés sur le prompt engineering — l’art de formuler la bonne question — la discipline a évolué. On parle de plus en plus de context engineering.

Quand les moteurs de recherche plafonnent

Depuis deux décennies, l’expérience du numérique est dominée par les moteurs de recherche. Tapez les bons mots, et espérez que l’algorithme vous comprenne sans rien savoir de vous ou du contexte de votre demande. Car la réalité est crue : le moteur ne sait rien de vous, ni de ce que vous savez déjà, ni de ce que vous cherchez réellement. Il scanne, indexe, trie… sans mémoire. À l’inverse, les grands modèles de langage (LLM) comme ChatGPT, Claude ou Gemini, sont conçus pour intégrer un contexte vaste, dynamique, et personnalisé.

Cela change tout. Les résultats ne dépendent plus seulement de la requête, mais de l’univers que vous installez autour. Vous ne posez plus une question dans le vide, vous amorcez un dialogue, une mise en situation, un jeu de rôle. Et la qualité de la réponse peut grandement en bénéficier.

Le contexte, ce super carburant des LLM

Prenons un exemple simple : demander “écris un article sur l’intelligence artificielle.” Avec un moteur de recherche, on obtient une avalanche de liens, sans hiérarchie ni angle. Avec un LLM, le même prompt peut donner dix textes radicalement différents selon le contexte : pour un enfant de dix ans, dans un style humoristique, avec des références à Star Wars, ou sous forme de script de série Netflix.

Les LLM ne comprennent pas mieux — ils contextualisent mieux. Leur performance s’améliore significativement quand on leur fournit un cadre précis, un historique de la conversation, des préférences implicites, des règles à suivre. Bref, quand on contextualise la demande.

De la syntaxe au sens

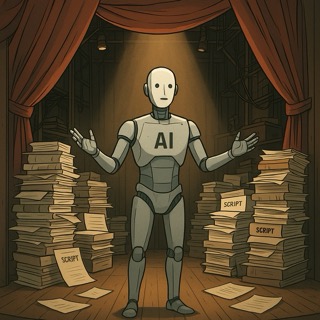

Dans les faits, on passe d’un paradigme de requête (search) à un paradigme de récit (LLM). Là où Google attend des mots-clés, ChatGPT attend une narration. Et c’est là que le context engineering devient stratégique : il ne s’agit plus de poser une bonne question, mais de concevoir le bon théâtre d’opérations.

On bâtit des systèmes entiers autour du contexte : un commercial équipe son assistant IA avec les infos de son CRM, un avocat insère des dossiers, un écrivain alimente l’IA avec ses brouillons. Plus le contexte est riche, pertinent, à jour, plus la réponse est fine. Moins c’est une réponse générique, et plus c’est une collaboration.

Le prompt engineering a muté

Le prompt engineering n’est pas obsolète, il s’est élargi. Il ne suffit plus d’écrire une belle phrase : il faut scénariser un écosystème d’information. Or cela exige une autre expertise : connaître les limites de mémoire contextuelle du modèle, structurer ses documents, formater ses données, équilibrer pertinence et concision.

Le vrai enjeu n’est pas d’automatiser des tâches, mais de préparer des environnements cognitifs sur mesure. Pour cela, il faut penser au-delà de la syntaxe : intégrer les usages, contrôler les biais, reconnaitre les intentions, scénariser l’expertise, définir les rôles.