C’est une question que je me pose depuis l’annonce d’Open AI de son GPT Store et d’un hypothétique programme de rémunération des créateurs de GPT.

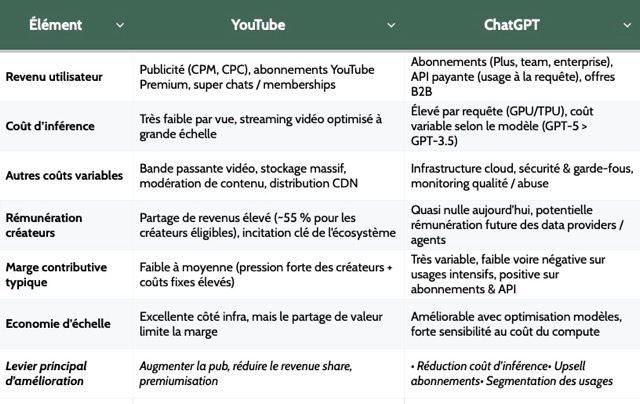

Comparer une plateforme d’assistants LLM à YouTube est possible, mais seulement si on met les deux modèles au même niveau comptable. Sur YouTube, le coût marginal d’une vue est faible, alors que sur une plateforme d’assistants, chaque interaction déclenche un coût variable d’inférence. C’est cette asymétrie qui décide de la soutenabilité d’un modèle similaire à YouTube.

Autrement dit, une rémunération créateurs sérieuse n’est plausible que si la plateforme rémunère en % du revenu net après coûts d’inférence, ou si elle dispose d’une monétisation très forte (abonnement, publicité, transactions) et d’un routage massif vers des modèles bon marché.

YouTube comme plateforme d’allocation de revenus

YouTube n’est pas seulement un hébergeur vidéo. C’est une machine d’allocation : elle mesure, partage, et distribue des revenus.

- Long-formats : le blog YouTube rappelle un partage à 55% pour les créateurs sur les revenus publicitaires de vidéos long-format (45% pour YouTube).

- Shorts : logique creator pool, avec un partage indiqué à 45% pour les créateurs et une mécanique d’allocation différente.

- Premium : partage des revenus YouTube Premium avec les créateurs regardés.

- Échelle publicitaire : dans le 10-K Alphabet, YouTube ads = 36,147 Md$ en 2024.

- Rentabilité : MoffettNathanson (via TheWrap) estime pour 2024 7,8 Md$ d’operating income et 14% de marge.

Cette architecture de reversement est tenable parce que le coût variable par unité consommée (une vue) est relativement bas à grande échelle. Le gros des coûts (infrastructure, modération, produit) s’amortit.

Chez ChatGPT, l’inférence est un coût variable

Dans le cadre d’un GPTStore des assistants, l’inférence change la donne car c’est un cout variable. Un assistant n’est pas seulement distribué : il est exécuté. À chaque requête, la plateforme consomme des tokens, donc du calcul, donc un coût variable. Même si l’on utilise ici des prix publics (API) qui ne sont pas le coût interne réel, ils donnent un ordre de grandeur et un langage commun.

- Proxy prix API : GPT-5.2 est affiché à 1,75 $ / 1M tokens input et 14 $ / 1M tokens output.

- Routage : la grille montre des modèles nettement moins coûteux (ex. mini/nano) et donc la possibilité de baisser le coût moyen par routage.

- Cache : la doc “Prompt caching” annonce une réduction possible jusqu’à 90% du coût input.

Conséquence : rémunérer des créateurs d’assistants revient bien à un content acquisition cost (comme chez YouTube), mais avec une contrainte supplémentaire : il faut intégrer le coût d’inférence dans la même équation.

Raisonner en marge contributive

Si on veut une comparaison propre, il faut une métrique commune, orientée marge contributive, avant coûts fixes :

Marge contributive = (Revenu utilisateur) − (Coût d’inférence) − (Autres coûts variables) − (Rémunération créateurs)

YouTube peut afficher des reversements élevés parce que le coût variable par unité consommée est faible. Une plateforme d’assistants, elle, doit choisir :

- soit elle paie en % d’un revenu après inférence

- soit elle plafonne l’usage, soit elle augmente l’ARPU

- soit elle route le plus possible vers des modèles bon marché

Le stress test

Objectif : estimer combien une plateforme d’assistants peut reverser aux créateurs sans casser une marge contributive cible, une fois qu’on a payé le coût variable le plus spécifique : l’inférence.

1. La marge contributive cible

On fixe une marge contributive cible de 15% sur un abonnement à 20 $/mois.

- Revenu mensuel utilisateur : 20 $

- Marge contributive cible : 15% car la plateforme veut garder 3 $ (20 × 0,15)

- Donc l’enveloppe maximale de coûts variables (tout compris) est : 17 $ (20 − 3)

Si vos coûts variables dépassent 17 $, vous passez sous la marge cible et vous perdez de l’argent.

2. Les coûts variables retenus dans la simulation

- Autres coûts variables (paiement, support) : 1 $/mois

- Coût d’inférence : on utilise un prix proxy basé sur les prix API, car le coût interne réel n’est pas public

Pourquoi un proxy ? Le prix API public n’est pas le coût interne, c’est un prix de vente. On introduit donc un facteur f :

- Coût interne estimé = f × coût proxy

Exemples : f=20% (optimiste) et f=50% (prudent)

3. Les trois profils d’usage

On segmente trois profil d’usage client.

- Light : 0,2M output + 0,5M input

- Medium : 0,8M output + 2M input

- Heavy : 2M output + 5M input

Pourquoi séparer input/output ? Parce que l’output est beaucoup plus cher.

4. Calcul du coût

coût proxy = 14$ × output(M) + 1,75$ × input(M)

- Light : 14×0,2 + 1,75×0,5 = 2,8 + 0,875 = 3,68 $

- Medium : 14×0,8 + 1,75×2 = 11,2 + 3,5 = 14,7 $

- Heavy : 14×2 + 1,75×5 = 28 + 8,75 = 36,75 $

5. Solde disponible pour payer les créateurs

On part de l’enveloppe max de coûts variables : 17 $.

On retire :

- les autres coûts variables : 1 $

- le coût d’inférence estimé en interne : f × coût proxy

Donc :

Rémunération créateurs max = 17 − (f × coût_proxy) − 1

6. Deux scénarii f=20% et f=50%

| Profil util. | Coût proxy | Coût interne (f=20%) | Rem. max (f=20%) | Coût interne (f=50%) | Rem. max (f=50%) |

|---|---|---|---|---|---|

| Light | 3,68 $ | 0,74 $ | 15,27 $ | 1,84 $ | 14,16 $ |

| Medium | 14,70 $ | 2,94 $ | 13,06 $ | 7,35 $ | 8,65 $ |

| Heavy | 36,75 $ | 7,35 $ | 8,65 $ | 18,38 $ | -2,38 $ |

7. La leçon à retenir

Plus l’usage est heavy, plus l’inférence consomme l’enveloppe variable, et plus la rémunération des créateurs s’effondre. Si le coût interne est élevé (scénario f=50%), un utilisateur heavy rend le modèle intrinsèquement non soutenable à 20 $/mois.

On peut cependant considérer que dans le cadre d’assistants de type agent, le cout d’utilisation peut-être simulé à l’avance. L’agent effectue toujours la même tâche, les input / output sont connus et relativement stables. On récupère une marge de manoeuvre.

Implication produit : une rémunération des créateurs doit être définie en % du net après inférence ou via un pool, sinon la plateforme se retrouve à subventionner les usages les plus coûteux.

Trois schémas de rémunération

La conclusion pratique de ce stress-test est simple : éviter un x% du CA brut comme promesse structurante. Les schémas robustes sont ceux qui protègent la marge lorsque l’usage devient coûteux.

a. Partage sur le net after inference

Créateurs = α × (revenus attribués à l’assistant − coût d’inférence attribué)

C’est l’analogue le plus sain d’un partage YouTube : on rémunère une création qui génère de la valeur, mais on ne subventionne pas un coût d’exécution non maîtrisé.

b. Pool fixe avec redistribution à la valeur

Un pool alimenté par l’abonnement et la pub, redistribué selon des métriques de succès (résultat, satisfaction), plutôt que selon du volume brut. On peut supposer que l’avancée de Open AI vers le e-commerce pourrait donner lieu à une rémunération de type affiliation sur conversion ou CA.

L’alimentation par la publicité est de sont coté cohérente avec l’idée d’un paiement basé sur l’engagement évoquée par OpenAI pour le GPT Store.

c. Commission

A l’image des App stores, Apple prend 15% de commission pour le Small Business Program.

Ce modèle devient crédible si la plateforme facture l’utilisateur sur une unité qui couvre l’inférence (abonnement segmenté, crédits, usage), et si la commission s’applique sur une valeur après exécution.

La monétisation au-delà de l’abonnement

Si la plateforme veut financer à la fois l’inférence et une économie créateur, elle a intérêt à élargir le mix :

- Abonnement : stable mais contraint par le coût des heavy users.

- Publicité : permet de financer une partie du coût d’usage sur les offres gratuites mais introduit des sujets de confiance et d’attribution. (OpenAI indique vouloir tester la publicité sur ChatGPT Free et Go aux États-Unis).

- Routage + cache : baisse le coût moyen, donc agrandit mécaniquement le budget créateurs à ARPU constant.

Pour la plateforme, le point d’attention n’est pas seulement où se trouve l’audience, mais quel indicateur la plateforme optimise. Exemple : Une plateforme d’assistants peut être tentée de maximiser des métriques d’engagement, mais ceux-ci risquent d’augmenter le coût d’inférence et donc dégrader sa rentabilité.

Le modèle tient si la plateforme rémunère après le coût d’inférence

Oui, un YouTube des assistants peut fonctionner, mais seulement si la plateforme internalise une règle comptable stricte : la rémunération créateurs se calcule après le coût variable d’inférence, ou via un pool calibré sur une marge contributive cible. Les reversements élevés deviennent alors un résultat : efficacité du routage, coût moyen bas, ARPU solide.

Dans ce cadre, la comparaison avec YouTube redevient utile : non pas comme analogie de produit, mais comme rappel que la plateforme qui gagne est celle qui maîtrise l’allocation (mesure, distribution, partage) sans perdre le contrôle de son coût marginal.

NB : Cette analyse est essentiellement comptable, pour considérer une plateforme de créateurs d’agents il reste d’autres sujets à investiguer. Je pense entre autres à l’absence de barrières à l’entrée et à la concurrence intrinsèque entre le modèle central et les agents.

Sources

- YouTube – YouTube Partner Program, Explained

- Découvrez le GPT Store

- Google Help – YouTube Shorts monetization policies

- Alphabet – 10-K 2024 (PDF)

- TheWrap – estimation MoffettNathanson

- OpenAI – API Pricing

- OpenAI Platform – Pricing

- OpenAI Platform – Prompt caching

- OpenAI – Our approach to advertising and expanding access

- Apple Developer – App Store Small Business Program